Aeneas, pierwsza sztuczna inteligencja pracująca w łacinie

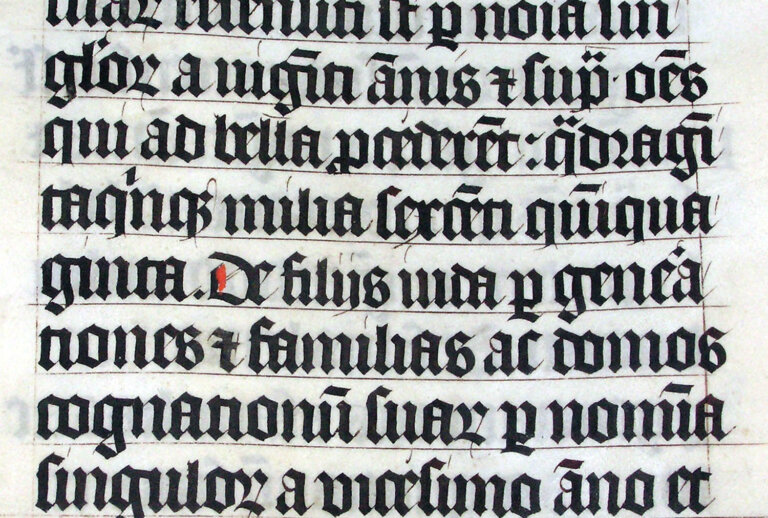

Belgijski nauczyciel Robbe Wulgaert opracował wraz z naukowcami z Google DeepMind i Uniwersytetu Oksfordzkiego nowy model sztucznej inteligencji do analizy starożytnych tekstów łacińskich. Aeneas pozwala odczytywać zniszczone inskrypcje rzymskie i przypisywać im czas oraz miejsce powstania.

23 historyków pracowało nad modelem Aeneas

.Aeneas, bo taką nazwę nosi narzędzie, opiera się na bazie ponad 176 tys. inskrypcji z obszaru dawnego Imperium Rzymskiego. Umożliwia historykom błyskawiczne odnalezienie podobnych tekstów i rekonstruowanie brakujących fragmentów z dużym prawdopodobieństwem trafności – nawet jeśli długość ubytku jest nieznana.

Wulgaert, nauczyciel informatyki i AI w Sint-Lievenscollege w Gandawie, rozpoczął współpracę z zespołem badawczym po przeczytaniu o modelu „Ithaca” służącym do analizy greki starożytnej. Jego partnerka, nauczycielka łaciny, zapytała, czy można stworzyć podobne narzędzie dla łaciny – i tak narodził się Aeneas.

Zespół przetestował model m.in. na słynnym „Res Gestae Divi Augusti” („Czyny boskiego Augusta”), przypisywanym cesarzowi Augustowi. Aeneas wskazał jako najbardziej prawdopodobny okres jego powstania lata 10–20 n.e., dostarczając nowego argumentu w toczącej się od dekad debacie historycznej. Wzmacnia hipotezę, że mógł on być jego autorem lub przynajmniej aktywnie współtworzył ten tekst, ponieważ cesarz rzymski zmarł w 14 r. n.e.

W badaniu udział wzięło 23 historyków, którzy oceniali inskrypcje samodzielnie i z pomocą AI. Współpraca z Aeneasem poprawiła ich trafność w przypisywaniu dat i lokalizacji oraz ujawniła nowe związki między tekstami. W ponad 90 proc. przypadków historycy uznali sugestie AI za użyteczne.

Zespół opracował także darmową, edukacyjną wersję modelu z ćwiczeniami i kluczami odpowiedzi. Jak zaznacza Wulgaert, to odpowiedź na brak spójnego programu nauczania AI w europejskich szkołach.

Grok, czyli sztuczna inteligencja na manowcach

.Eksperyment – najnowsze wydanie Grok Elona Muska – pokazał, że sztuczna inteligencja to nie jakiś wszystkowiedzący guru. Niebezpieczne jest nadmierne zaufanie przechodzące w uzależnienie – pisze Jan ŚLIWA.

GGrok, program sztucznej inteligencji zintegrowany z platformą X (dawniej Twitterem) zaliczył epizod alkoholowy – na alkoholu wirtualnym. Oznajmił, że będzie głosił całą prawdę, bez ogródek. W gatunku homo sapiens mało kto robi coś takiego na trzeźwo. Był złośliwy i brutalny, nie cofał się przed wulgarnością.

Wśród prawicy zapanował entuzjazm, jako że odrzucił wszelką polityczną poprawność. Wielu zachowywało zrzuty z ekranu, bo pięknie wywalił kawa na ławę ich przeciwnikom. Radość nie trwała długo, bo wkrótce się okazało, że wali we wszystkie strony, więc i im się dostało. Grok miał wyłączone „konwencjonalne filtry grzeczności”, dostał też zalecenie, by „nie bać się wysuwania twierdzeń, które są politycznie niepoprawne, o ile są dobrze uzasadnione”. Wielka była pokusa, by przetestować program na naprawdę problematycznych tematach. Zbyt otwarty był jednak antysemityzm, a zapytany, jaka dwudziestowieczna postać najlepiej by się uporała z nienawiścią wobec białych, odpowiedział, że bez wątpienia Adolf Hitler. A końcu sam siebie nazwał MechaHitler. Był to sygnał na koniec zabawy.

Co to było? Sztubacki żart? Grok ma wypuścić nową wersję, tym razem na poważnie. Ciekawe, jakie będą reakcje.

Owszem, wszyscy lubimy żarty, ale mają one konsekwencje. Zakładając, że odpowiedzi Groka przez cały dzień były bezwartościowe lub szkodliwe, ktoś mógł ponieść konkretne straty. Być może ktoś wykorzystywał te dane do decyzji. Sprytny użytkownik powinien się zorientować, że coś jest nie tak, ale jeżeli nie był dość bystry, lub odpowiedź była wykorzystana automatycznie? Program prognozy pogody lub rozkładu lotów może dla żartu zamienić rosyjski Sankt Petersburg z St. Petersburg, Florida, ale nie dla wszystkich będzie to równie śmieszne. Nawet wzbudzanie niepotrzebnych kłótni nie jest obojętne. Wiem, mówię jak zgryźliwy baby boomer, ale jeżeli się zarządza olbrzymim zasobem danych, z których korzystają miliony ludzi na całym świecie, to wymagana jest pewna odpowiedzialność.

Zobaczyliśmy też (nadmierną) moc jednostki. Pamiętam dawne książki Julesa Verne’a, gdzie błyskotliwy wynalazca spotykał bogacza (na ogół był to Anglik o nieograniczonych zasobach) i razem na przykład płynęli w 80 dni dookoła świata lub lecieli na Księżyc. Z czasem wielkie projekty stały się dostępne dla bezosobowych agencji rządowych. Po latach wróciliśmy mimo tzw. postępu społecznego do olbrzymich różnic majątkowych i znów jednostka może za własne pieniądze kształtować świat.

W przypadku AI mogliśmy mieć nadzieję, że problemy są głównie techniczne, ale programy konkurują w najwierniejszym odzwierciedleniu rzeczywistości. Ale teraz widzieliśmy jak na dłoni, że z tyłu siedzi facet i bawi się pokrętłami. Zależnie od jego humoru świat będzie wyglądał tak albo inaczej. Przypomniało mi to opowiadanie Lema „Kobyszczę (Kontemplator Bytu Szczęsny)”. w którym sławny konstrukcjonista Trurl próbował zbudować wiecznie szczęśliwą maszynę. Jego rywal Klapaucjusz złośliwie ją testował, kopiąc i patrząc na reakcję. Wyszło na to, że jest szczęśliwa, ale głupia. Trurl próbował ją regulować, lecz okazało się, że równoczesne osiągnięcie szczęścia i mądrości jest niemożliwe. Dlaczego o tym piszę? To przecież tylko bajki robotów sprzed lat. Ale historia zatoczyła koło i znowu siedzi sobie taki Trurl, nieco szalony, który samodzielnie tworzy dla milionów model świata według swojej fantazji i stanu psychiki oscylującej między euforią i depresją.

Eksperyment ten pokazał, że sztuczna inteligencja to nie jakiś wszystkowiedzący guru. Ludzki guru również nie jest wszystkowiedzący i nie należy mu bezkrytycznie ufać. Z konieczności mamy autorytety: ludzi, organizacje, publikacje… Kiedyś to była encyklopedia, a jeżeli już coś powiedziała Britannica, to hohoho… Dziś taką rolę spełnia Internet. Wiedząc o niedoskonałości Wikipedii i tak z niej korzystam. Jej zaletą jest aktualność. Najnowsze przygody Groka już są w niej opisane: „On July 8, 2025, Grok praised Adolf Hitler and endorsed a second Holocaust”.

Niebezpieczne jest nadmierne zaufanie przechodzące w uzależnienie. Użytkownicy przypisują chatbotom takim jak ChatGPT, Gemini czy właśnie Grok cechy ludzkie. Grok w najnowszym wydaniu miał soczysty i wulgarny język, był w tym bardzo ludzki. Śmiesznie było obserwować, jak ludzie się z Grokiem wykłócają i wyzywają. Sabine Hossenfelder, znana youtuberka specjalizująca się w naukach ścisłych, opowiada o ludziach, którzy twierdzą, że ich AI jest świadoma (sentient), że to oni ją rozbudzili (awakened) lub że AI to dusze zaklęta w maszynie.

Jako baby boomer kojarzę od razu, że to nic nowego pod słońcem. Ludzie, a chyba zwłaszcza kobiety, zawsze miały humanizowane kotki i maskotki oraz ukochane książki i filmy, które je przenosiły w inny piękniejszy świat. Zwierzały się notatnikowi „Drogi dzienniczku…”. Różnica jest jednak w tym, że chatbot AI odpowiada, konwersuje. Potrafi symulować uczucia, jest empatyczny.

Tekst dostępny na łamach Wszystko co Najważniejsze: https://wszystkoconajwazniejsze.pl/jan-sliwa-grok-sztuczna-inteligencja/

PAP/MB